文|元宇宙日爆

(资料图片)

(资料图片)

一份被意外泄露的谷歌内部文件,将 Meta 的 LLaMA 大模型 " 非故意开源 " 事件再次推到聚光灯前。

" 泄密文件 " 的作者据悉是谷歌内部的一位研究员,他大胆指出,开源力量正在填平 OpenAI 与谷歌等大模型巨头们数年来筑起的护城河,而最大的受益者是 Meta,因为该公司 2 月意外泄露的 LLaMA 模型,正在成为开源社区训练 AI 新模型的基础。

几周内,开发者与研究人员基于 LLaMA 搞起微调训练,接连发布了 Alpaca、Vicuna、Dromedary 等中小模型,不只训练成本仅需几百美元,硬件门槛也降低至一台笔记本电脑甚至一部手机,测试结果不比 GPT-4 差。

除了 AI 模型之外,FreedomGPT 等类 ChatGPT 应用也如雨后春笋般涌现,基于 LLaMa 的 " 羊驼家族 " 不断壮大,这位研究员认为,Meta 很可能借此形成生态,从而成为最大赢家。

事实上,人工智能的世界里,的确有一部分进入了 " 安卓时刻 ",这个部分就是开源社区。特斯拉前 AI 主管 Andrej Karpathy 评价开源社区中的 AI 进化时称,他看到了 " 寒武纪大爆发的早期迹象 "。

在 AI 竞速的赛道上,奔跑的不只有科技巨头,开源社区正在从小径中涌入大道,成为人工智能开发层面不可忽视的力量。

LLaMa 意外开源养出 " 羊驼家族 "

" 我们没有护城河,OpenAI 也没有。" 一篇来自 Google 内部的文章在 SemiAnalysis 博客传播,文章作者认为,Meta 的 LLaMa 开源模型快速聚集起生态雏形,正在消除与 GPT 之间的差距,开源 AI 最终会打破 Google 与 OpenAI 的护城河。

这篇文章让人重新注意到了 Meta 的 LLaMA 大模型,该模型代码被泄露后的 2 个月里意外成了开源社区训练自然语言模型的基础,还产生了诸多中小模型及应用。

时间回到今年 2 月 24 日,Meta 推出大语言模型 LLaMA,按参数量分为 7B、13B、33B 和 65B 四个版本。别看参数量远远不及 GPT-3,但效果在 AI 圈内获得了一些正面评价,尤其是能在单张 GPU 运行的优势。

Meta 在官方博客中曾称,像 LLaMA 这种体积更小、性能更高的模型,能够供社区中无法访问大量基础设施的人研究这些模型,进一步实现人工智能大语言模型开发和访问的民主化。

" 民主化 " 来得异常快。LLaMA 推出一周后,一位名叫 llamanon 的网友在国外论坛 4chan 上以种子文件的方式上传了 7B 和 65B 的 LLaMA 模型,下载后大小仅为 219GB。此后,这个种子链接被发布到开源社区 GitHub,下载量超过千次。LLaMA 就这样被泄露了,但也因此诞生了诸多实验成果。

最初,名叫 Georgi Gerganov 的开发者开源了一个名为 llama.cpp 的项目,他基于 LLaMA 模型的简易 Python 语言的代码示例,手撸了一个纯 C/C++ 语言的版本,用作模型推理。换了语言的最大优势就是研究者无需 GPU、只用 CPU 能运行 LLaMA 模型,这让大模型的训练硬件门槛大大降低。

正如谷歌那位研究员写得那样," 训练和实验的门槛从一个大型研究机构的全部产出降低到 1 个人、1 晚上和 1 台性能强大的笔记本电脑就能完成。" 在开发者的不断测试下,LLaMA 已经能够在微型计算机树莓派 4 和谷歌 Pixel 6 手机上运行。

开源社区的创新热情也彻底点燃,每隔几天都会有新进展,几乎形成了一个 "LLaMA(羊驼)生态 "。

3 月 15 日,斯坦福大学微调 LLaMA 后发布了 Alpaca(美洲驼)模型,仅用了 52K 数据,训练时长为 3 小时。研究者宣称,测试结果与 GPT-3.5 不分伯仲,而训练成本还不到 600 美元,在一些测试中,Alpace 与 GPT-3.5 的获胜次数分别为 90 对 89。

随后,加州大学伯克利分校、卡内基梅隆大学、加州大学圣地亚哥分校的研究人员又提出新的模型 Vicuna(小羊驼),也是基于 LLaMa 做出来的,训练成本仅 300 美元。

在该项目的测评环节,研究人员让 GPT-4 当 " 考官 ",结果显示,GPT-4 在超过 90% 的问题中更强倾向于 Vicuna 的回答,并且 Vicuna 在总分上达到了 ChatGPT 的 92%。

用 GPT-4 测评 Vicuna 与其他开源模型短短几周,基于 LLaMa 构建的 " 羊驼家族 " 不断壮大。

4 月 3 日,伯克利人工智能研究院发布了基于 LLaMa 微调的新模型 Koala(考拉),训练成本小于 100 美元,在超过一半的情况下与 ChatGPT 性能相当;5 月 4 日,卡内基梅隆大学语言技术研究所、IBM 研究院与马萨诸塞大学阿默斯特分校的研究者们,推出了开源自对齐语言模型 Dromedary(单峰骆驼),通过不到 300 行的人工标注,就能让 65B 的 LLaMA 基础语言模型在 TruthfulQA(真实性基准)上超越 GPT-4。

在国内,垂直医疗领域的 " 羊驼家族 " 成员也出现了,哈尔滨工业大学基于 LLaMa 模型的指令微调,推出了中文医学智能问诊模型 HuaTuo(华驼),该模型能够生成专业的医学知识回答。

哈工大推出中文医学智能问诊模型 HuaTuo(华驼)基于该模型的开源创新不仅在大模型上,应用层也有多点开花之势。

3 月 31 日,AI 公司 Age of AI 推出了语言模型 FreedomGPT,正是基于斯坦福大学的 Alpaca 开发出来的;3 月 29 日,加州大学伯克利分校在它的 Colossal-AI 基础下发布了 ColossalChat 对话机器人,能力包括知识问答、中英文对话、内容创作、编程等。

从基础模型层到应用层,基于 LLaMa 所诞生的 " 羊驼家族 " 还在一路狂奔。由于被 " 开源 " 的 LLaMA 出自 Meta 之手,那位发文的谷歌研究员认为,Meta 意外成了这场 AI 竞争中的最大受益者——借助开源社区的力量,Meta 获得了全世界顶级开发者的免费劳动力,因为大多数开源的 AI 创新都发生在他们的基础架构内,因此,没有什么能阻止 Meta 将这些成果直接整合到他们的产品中。

开源力量触发 "AI 的安卓时刻 "

ChatGPT 引爆 AI 热后,英伟达的 CEO 黄仁勋将这股浪潮喻为 "AI 的 iPhone 时刻 ",他认为,AI 行业进入了如 iPhone 诞生颠覆手机行业时的革命性时间点。而当 LLaMA 开启开源社区的小宇宙后,网友认为,"AI 的安卓时刻 " 来了。

回顾过去,谷歌曾以开源思想让更多的开发者参与到安卓应用生态的建设中,最终让安卓成为电脑与手机的系统 / 应用主流。如今,LLaMA 再次让 AI 业内看到了开源力量的强大。

智能软硬件件开发公司出门问问的 CEO 李志飞也注意到了谷歌这篇内部声音:

" 大模型这个领域,Google 已经在声势上大幅落后于 OpenAI。在开源生态上,如果 Google 再犹豫不决,后面就算想开源也会大幅度落后于 Meta 的 LLaMA。相反,如果开源,可以把 OpenAI 的壁垒进一步降低,而且会吸引(或留住)很多支持开源的高级人才。"

特斯拉前 AI 主管 Andrej Karpathy 认为:

" 当前开源大模型的生态之势,已经有了寒武纪大爆发的早期迹象。"

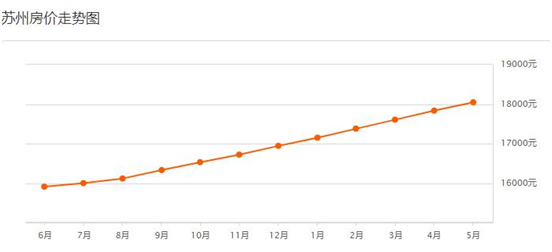

确实,开发者对开源的 AI 模型前所未有的热情正在从 Github 的打星量指标中溢出:Alpaca 获得了 23.2k 星,llama.cpp 获 26.3k 星,LLaMA 获 20.8k 星……而在 " 羊驼家族 " 之前,AutoGPT 等开源项目也在 Github 拥有超高的人气,突破 100k 星。

开发者对开源 AI 模型的打星量此外,为了追赶 ChatGPT,构建大型开源社区的 AI 初创公司 Hugging Face 也在近日推出了开源聊天机器人 HuggingChat,该机器人的底层模型拥有 300 亿个参数,并对外开放了训练数据集。英伟达 AI 科学家 Jim Fan 认为,如果后续开发应用程序,Hugging Face 将比 OpenAI 更具优势。

开源力量来势汹汹,手握 OpenAI 的微软也并不准备把鸡蛋都放在一个篮子里。今年 4 月,微软推出了开源模型 DeepSpeed Chat,为用户提供了 " 傻瓜式 " 操作,将训练速度提升了 15 倍。

以 LLaMA 为核心的 AI 开源社区正在平行空间中,与 OpenAI 等走闭源路线的大模型巨头展开竞速,开源思想与实践中爆发出的创新力量已经不容巨头小觑了。

更多精彩内容,关注钛媒体微信号(ID:taimeiti),或者下载钛媒体 App

关键词: